在当今信息爆炸的时代,数据分析成为了决策过程中不可或缺的一环,无论是商业策略的制定、市场趋势的预测,还是社会现象的解析,精准的数据支撑都是成功的关键,面对海量数据和复杂的分析任务,即便是资深的数据分析师也难免会遇到各种挑战与“险阻”,本文将基于一个虚构的案例——“二四六香港资料期期准千附三险阻”,探讨如何通过有效的方法和技术手段来克服这些障碍,确保数据分析的准确性和实用性,进而为决策者提供有力的支持。

一、案例背景介绍

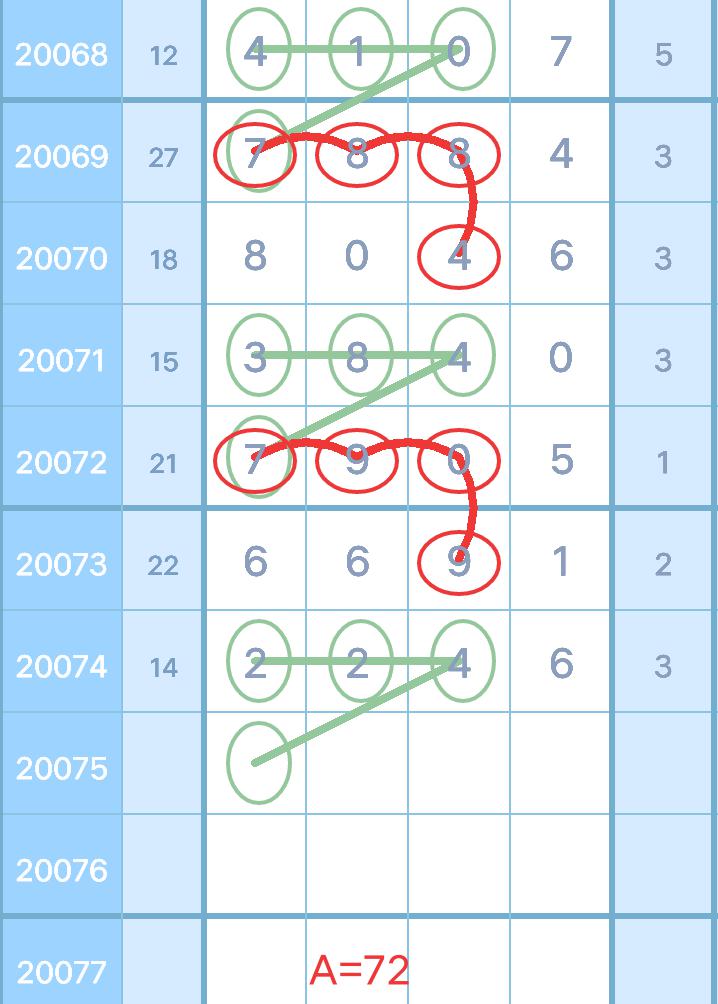

假设我们正在处理一份关于香港地区某项特定活动(如彩票开奖)的历史记录数据集,其中包含了从2000年至2023年间所有开奖结果的信息,该数据集被命名为“二四六香港资料”,意指每周二、四、六进行的数据收集工作,这份资料不仅包含了基本的开奖号码,还附带了每期参与者数量、奖金分配情况等详细信息,共计上千条记录(“千附”),根据初步审查发现存在三大主要问题或难点,即所谓的“三险阻”:

1、数据质量参差不齐:由于时间跨度较长且来源多样,部分早期数据存在缺失值或者格式不一致的情况。

2、特征工程复杂:除了基础数字外,还需要挖掘更多潜在影响因素作为模型输入变量。

3、模型选择与验证困难:面对如此庞大的数据集,如何选择合适的机器学习算法并有效评估其性能成为一大难题。

二、解决方案概述

针对上述挑战,我们可以采取以下步骤逐步解决:

1. 数据清洗与预处理

- 使用Python中的Pandas库对原始CSV文件进行读取,并利用其强大的数据处理能力完成缺失值填补、异常值检测等工作。

- 对于格式不统一的问题,则需编写自定义函数转换特定字段至标准形态。

- 通过可视化工具检查清洗后的数据分布情况,确保没有明显偏差。

2. 特征工程

- 结合业务知识和领域专家意见,识别出可能影响结果的关键因素,比如节假日效应、天气状况等。

- 利用Scikit-learn等库生成新的特征列,并通过相关性分析筛选出最相关者加入最终训练集。

- 考虑引入时间序列相关特性,如移动平均线、季节性指数等,以捕捉长期趋势变化。

3. 模型构建与优化

- 根据问题性质选用合适的监督学习模型,例如逻辑回归用于分类预测;随机森林或梯度提升树适用于回归问题。

- 采用交叉验证法分割数据集,保证测试集独立于训练过程之外,从而获得更加客观公正的结果。

- 调整超参数设置,运用网格搜索等方式寻找最佳组合,提高整体预测准确率。

4. 结果解释与应用

- 利用SHAP值(Shapley Additive Explanations)等可解释性工具深入剖析每个样本的贡献度,帮助理解模型行为背后的原因。

- 将经过充分验证的模型部署到生产环境中,定期监控其表现并及时调整策略应对新的数据模式。

- 撰写详细的报告文档,向非技术人员清晰地传达研究发现及其实际应用价值。

三、结论

通过对“二四六香港资料期期准千附三险阻”这一假想场景下的具体操作流程介绍,我们可以看到,在面对复杂多变的大数据分析任务时,科学合理地规划每一步行动至关重要,只有当各个环节紧密衔接、相互配合得当时,才能真正发挥出数据的最大效能,为企业带来实质性的好处,同时值得注意的是,随着技术不断进步与发展,未来还将涌现出更多高效便捷的工具和方法供从业者使用,但无论如何变化,扎实的基本功永远是立身之本,希望以上内容能够为广大同行提供一些启示和参考!

转载请注明来自济南市新阳光国医馆中医门诊部,本文标题:《二四六香港资料期期准千附三险阻,构建解答解释落实_i881.72.00》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...